deepseek本地部署详细指南

一、部署前准备 硬件配置要求 基础配置: CPU:Intel i5-12代/AMD Ryzen 5 5600X(4核8线程)及以上。 内存:16GB DDR4(7B模型)或32GB(32B模型)。 存储:NVMe SSD≥500GB(建议预...

一、部署前准备 硬件配置要求 基础配置: CPU:Intel i5-12代/AMD Ryzen 5 5600X(4核8线程)及以上。 内存:16GB DDR4(7B模型)或32GB(32B模型)。 存储:NVMe SSD≥500GB(建议预...

以下是使用 Docker + Dify + DeepSeek 搭建本地知识库的详细方案,结合 Ollama 模型运行 和 Dify 可视化管理,实现高效、安全的私有化部署: 一、核心工具与优势 Docker 作用:容器化部署,隔离环境,避免...

DeepSeek(深度求索)是由杭州深度求索人工智能基础技术研究有限公司开发的人工智能平台,专注于大语言模型(LLMs)的研发与应用,目前相当的火爆,它可以帮助我们完成许多工作。而本地部署的DeepSeek能够保护用户的隐私防止泄露,也...

DeepSeek是一款高性能的AI模型,其性能可与OpenAI的o1模型媲美,适用于多种复杂应用场景。通过本地部署,用户不仅能充分发挥DeepSeek的强大功能,还能显著提升数据的隐私性和安全性,非常适合对数据控制有高要求的企业或个人。 D...

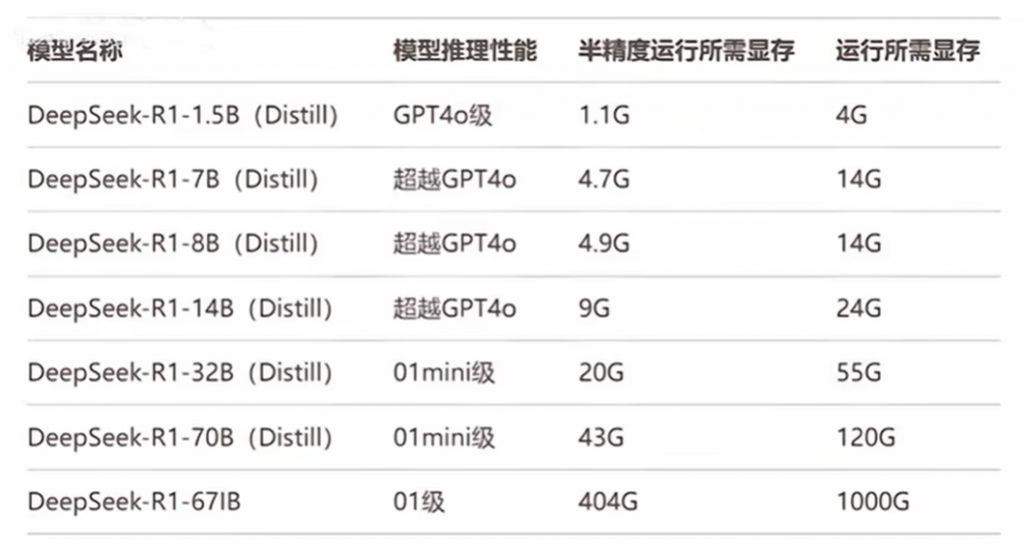

DeepSeek 是一款开源且性能强大的大语言模型,以其低成本和高性能受到了众多关注。很多朋友想要在本地部署 DeepSeek,以享受离线使用、更好的数据安全和隐私保护等优势。DeepSeek本地部署的显卡需求因模型规模而异,具体如下: 一...

DeepSeek本地部署的存储空间需求与模型版本直接相关,具体如下: 1、轻量级模型: 1.5B/7B版本:约需3-10GB存储空间。例如,使用Ollama工具部署时,1.5B模型需1.1GB空余空间,7B模型需4.7GB。 适用场景:个人...

DeepSeek-V3与R1的强弱需结合具体场景判断:V3在通用任务、多语言处理及成本效益上表现更优,而R1在逻辑推理、数学计算及专业领域攻坚中更具优势。以下为具体分析: 通用任务与多语言处理 DeepSeek-V3作为多模态通用大模型,在...

DeepSeek是一家专注于人工智能技术研发的中国公司 ,致力于开发高性能、低成本的大语言模型(LLM)和相关技术。其目标是让AI技术更加普惠,使更多人和企业能够使用强大的AI工具。 一、DeepSeek的核心特点包括: 1、高性能与低成本...